30+ парсеров для сбора данных с любого сайта

Содержание:

- Видеоинструкция по оформлению заказа на парсер

- Rocket Reach

- A-Parser — парсер для профессионалов#

- Виды парсеров по технологии

- Виды парсеров по сферам применения

- Парсеры сайтов в зависимости от используемой технологии

- Как выбирать парсер email адресов?

- Возможности и преимушества#

- Зачем нужны парсеры

- Популярные парсеры для SEO

- Для чего парсить номера телефонов в «ВК»

- Законно ли это?

- ListGrabber

- Skrapp.io

Видеоинструкция по оформлению заказа на парсер

(смотреть на YouTube)

Чтобы заказать парсер сайта, отправьте на почту order@excelvba.ru

письмо с темой «Заказ парсера сайта», и в этом письме:

1) прикрепите ПРИМЕР РЕЗУЛЬТАТА в виде файла Excel,

содержащий строку заголовка, и как минимум одну строку с данными

Посмотреть пример файла Excel

Пожелания к оформлению файла-примера

- если файл содержит исходные данные (например, список ссылок или артикулов, по которым надо загружать данные) — в примере должно быть минимум 20-30 строк с исходными значениями (пример результата — в доп столбцах — может быть прописан для одной строки, но исходных значений, для тестирования парсера, должно быть несколько, — чем больше, тем лучше)

- расположите столбцы в нужном порядке, — именно в таком виде парсер будет выдавать результат

- если хотите, чтобы программа автоматически создавала / сохраняла файл результата, — укажите, в какой папке под каким именем сохранять

- пример нужен в виде файла Excel или CSV (а не скриншот). Если CSV нужен для импорта на сайт, — прикрепите пример файла CSV в нужной кодировке.

2) опишите, с какого сайта какие данные нужно брать

Интересует не только адрес сайта, — но и как найти на сайте нужные данные (например, получить полный список всех товаров)

Касательно возможных ограничений сайта (лимиты, капча, и пр.)

Такое встречается очень редко (только для порталов с огромной посещаемостью, — типа Google, Яндекс, Авито, Beru, Ozon, и т.п.), — но, тем не менее, я всегда об этом предупреждаю:

Парсер — не какая-то волшебная программа, которая сможет обойти ограничения, сделанные для людей.

Если сайт выдаёт капчу (требует ввести текст с картинки) — потребуется настраивать автораспознавание капчи, или же пользователю парсера придётся вводить этот текст во всплывающем окне (наличие капчи усложняет настройку, что сказывается на стоимости)

Если сайт позволяет загрузить не более 100 страниц в сутки, — парсер не сможет обойти это ограничение (в таких случаях, иногда настройка парсера становится бессмысленной)

Потому, если вы знаете о каких-то ограничениях сайта, — сразу укажите это при заказе (чтобы можно было оценить сложность и возможность получения необходимых данных с сайта)

После отправки заказа парсера на почту order@excelvba.ru,

с вами свяжется наш сотрудник, который займётся настройкой парсера для вас, — с ним уже обсудите нюансы (если из задания будет не всё понятно) и стоимость настройки.

Rocket Reach

Предлагая самые точные базы адресов, Rocket Reach позволяет вам установить связь с профессионалами, которые важны для вашего бизнеса. Будь то маркетинг, продажи или рекрутинг, Rocket Reach отлично подходит для получения проверенных данных. Кроме того, Rocket Reach умеет синхронизироваться и подключаться к другим приложениям, вроде SalesForce, HubSpot и прочим CRM.

Функции:

- Расширенный поиск

- Расширение Chrome

- Массовый поиск

- API

- Интеграция с другими приложениями

Особенности:

- Точные данные

- Рекомендует другие действия, которые могут упустить конкуренты при выполнении той же работы (также предоставляет личные адреса электронной почты)

- Отчеты для получения лучших результатов

- Информация о последних тенденциях

Плюсы:

- Если вы хотите получить множество лидов, то это приложение для вас

- С этим приложением легче идентифицировать потенциальных клиентов, а данные, которые оно предоставляет, надежны

Минусы:

- Небольшое количество бесплатных поисков для пользователей, которые выбирают бесплатный тариф

- Плохой UX

Цены:

Rocket Reach предлагает 3 тарифных плана, которые могут оплачиваться ежемесячно или ежегодно. Это планы Essentials, Pro и Ultimate. Ежемесячно они стоят 59, 119 и 299 долларов соответственно. Ежегодно это 468, 948 и 2,388 долларов. Независимо от того, какой план вы хотите купить, Rocket Reach во всех предоставляет следующее:

- Круглосуточную поддержку

- Поддержку CM и ATS

- Экспорт в CSV

- Массовый поиск

- Полный доступ к API

Оценка:

4.1 из 5

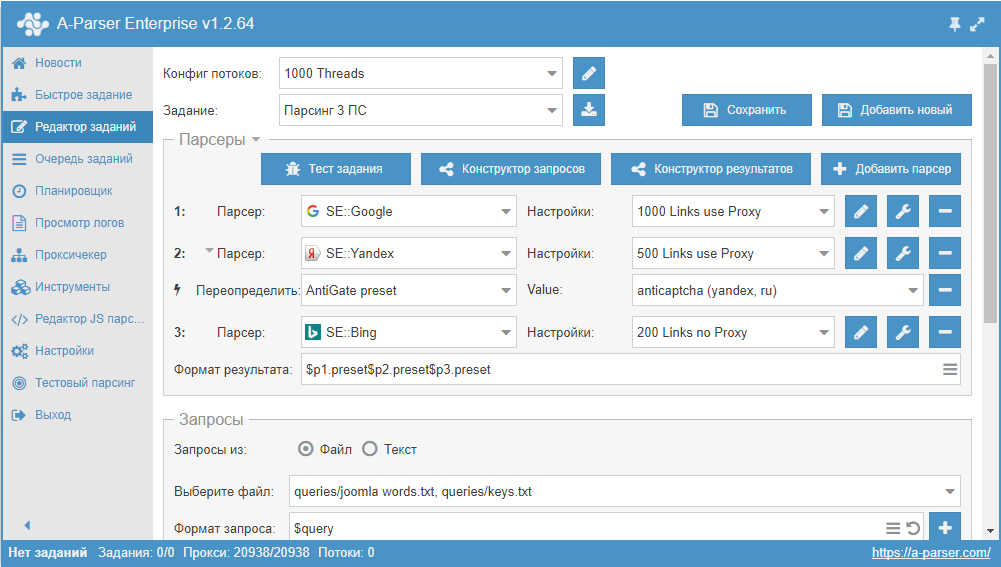

A-Parser — парсер для профессионалов#

A-Parser — многопоточный парсер поисковых систем, сервисов оценки сайтов, ключевых слов, контента(текст, ссылки, произвольные данные) и других различных сервисов(youtube, картинки, переводчик…), A-Parser содержит более 90 встроенных парсеров.

Ключевыми особенностями A-Parser является поддержка платформ Windows/Linux, веб интерфейс с возможностью удаленного доступа, возможность создания своих собственных парсеров без написания кода, а также возможность создавать парсеры со сложной логикой на языке JavaScript / TypeScript с поддержкой NodeJS модулей.

Производительность, работа с прокси, обход защиты CloudFlare, быстрый HTTP движок, поддержка управления Chrome через puppeteer, управлением парсером по API и многое другое делают A-Parser уникальным решением, в данной документации мы постараемся раскрыть все преимущества A-Parser и способы его использования.

Виды парсеров по технологии

Браузерные расширения

Для парсинга данных есть много браузерных расширений, которые собирают нужные данные из исходного кода страниц и позволяют сохранять в удобном формате (например, в XML или XLSX).

Парсеры-расширения — хороший вариант, если вам нужно собирать небольшие объемы данных (с одной или парочки страниц). Вот популярные парсеры для Google Chrome:

- Parsers;

- Scraper;

- Data Scraper;

- Kimono.

Надстройки для Excel

Программное обеспечение в виде надстройки для Microsoft Excel. Например, ParserOK. В подобных парсерах используются макросы — результаты парсинга сразу выгружаются в XLS или CSV.

Google Таблицы

С помощью двух несложных формул и Google Таблицы можно собирать любые данные с сайтов бесплатно.

Эти формулы: IMPORTXML и IMPORTHTML.

IMPORTXML

Функция использует язык запросов XPath и позволяет парсить данные с XML-фидов, HTML-страниц и других источников.

Вот так выглядит функция:

Функция принимает два значения:

- ссылку на страницу или фид, из которого нужно получить данные;

- второе значение — XPath-запрос (специальный запрос, который указывает, какой именно элемент с данными нужно спарсить).

Хорошая новость в том, что вам не обязательно изучать синтаксис XPath-запросов. Чтобы получить XPath-запрос для элемента с данными, нужно открыть инструменты разработчика в браузере, кликнуть правой кнопкой мыши по нужному элементу и выбрать: Копировать → Копировать XPath.

С помощью IMPORTXML можно собирать практически любые данные с html-страниц: заголовки, описания, мета-теги, цены и т.д.

IMPORTHTML

У этой функции меньше возможностей — с ее помощью можно собрать данные из таблиц или списков на странице. Вот пример функции IMPORTHTML:

Она принимает три значения:

- Ссылку на страницу, с которой необходимо собрать данные.

- Параметр элемента, который содержит нужные данные. Если хотите собрать информацию из таблицы, укажите «table». Для парсинга списков — параметр «list».

- Число — порядковый номер элемента в коде страницы.

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Есть специализированные парсеры для организаторов совместных покупок (СП). Их устанавливают на свои сайты производители товаров (например, одежды). И любой желающий может прямо на сайте воспользоваться парсером и выгрузить весь ассортимент.

Чем удобны эти парсеры:

- интуитивно понятный интерфейс;

- возможность выгружать отдельные товары, разделы или весь каталог;

- можно выгружать данные в удобном формате. Например, в Облачном парсере доступно большое количество форматов выгрузки, кроме стандартных XLSX и CSV: адаптированный прайс для Tiu.ru, выгрузка для Яндекс.Маркета и т. д.

Популярные парсеры для СП:

- SPparser.ru,

- Облачный парсер,

- Турбо.Парсер,

- PARSER.PLUS,

- Q-Parser.

Вот три таких инструмента:

- Marketparser,

- Xmldatafeed,

- ALL RIVAL.

Парсеры для быстрого наполнения сайтов

Такие сервисы собирают названия товаров, описания, цены, изображения и другие данные с сайтов-доноров. Затем выгружают их в файл или сразу загружают на ваш сайт. Это существенно ускоряет работу по наполнению сайта и экономят массу времени, которое вы потратили бы на ручное наполнение.

В подобных парсерах можно автоматически добавлять свою наценку (например, если вы парсите данные с сайта поставщика с оптовыми ценами). Также можно настраивать автоматический сбор или обновление данных по расписания.

Примеры таких парсеров:

- Catalogloader,

- Xmldatafeed,

- Диггернаут.

Парсеры сайтов в зависимости от используемой технологии

Парсеры на основе Python и PHP

Такие парсеры создают программисты. Без специальных знаний сделать парсер самостоятельно не получится. На сегодня самый популярный язык для создания таких программ Python. Разработчикам, которые им владеют, могут быть полезны:

- библиотека Beautiful Soup;

- фреймворки с открытым исходным кодом Scrapy, Grab и другие.

Заказывать разработку парсера с нуля стоит только для нестандартных задач. Для большинства целей можно подобрать готовые решения.

Парсеры-расширения для браузеров

Парсить данные с сайтов могут бесплатные расширения для браузеров. Они извлекают данные из html-кода страниц при помощи языка запросов Xpath и выгружают их в удобные для дальнейшей работы форматы — XLSX, CSV, XML, JSON, Google Таблицы и другие. Так можно собрать цены, описания товаров, новости, отзывы и другие типы данных.

Примеры расширений для Chrome: Parsers, Scraper, Data Scraper, kimono.

Парсеры сайтов на основе Excel

В таких программах парсинг с последующей выгрузкой данных в форматы XLS* и CSV реализован при помощи макросов — специальных команд для автоматизации действий в MS Excel. Пример такой программы — ParserOK. Бесплатная пробная версия ограничена периодом в 10 дней.

Парсинг при помощи Google Таблиц

В Google Таблицах парсить данные можно при помощи двух функций — importxml и importhtml.

Функция IMPORTXML импортирует данные из источников формата XML, HTML, CSV, TSV, RSS, ATOM XML в ячейки таблицы при помощи запросов Xpath. Синтаксис функции:

IMPORTXML("https://site.com/catalog"; "//a/@href")

IMPORTXML(A2; B2)

Расшифруем: в первой строке содержится заключенный в кавычки url (обязательно с указанием протокола) и запрос Xpath.

Знание языка запросов Xpath для использования функции не обязательно, можно воспользоваться опцией браузера «копировать Xpath»:

Вторая строка указывает ячейки, куда будут импортированы данные.

IMPORTXML можно использовать для сбора метатегов и заголовков, количества внешних ссылок со страницы, количества товаров на странице категории и других данных.

У IMPORTHTML более узкий функционал — она импортирует данные из таблиц и списков, размещенных на странице сайта. Синтаксис функции:

IMPORTHTML("https://https://site.com/catalog/sweets"; "table"; 4)

IMPORTHTML(A2; B2; C2)

Расшифруем: в первой строке, как и в предыдущем случае, содержится заключенный в кавычки URL (обязательно с указанием протокола), затем параметр «table», если хотите получить данные из таблицы, или «list», если из списка. Числовое значение (индекс) означает порядковый номер таблицы или списка в html-коде страницы.

Как выбирать парсер email адресов?

На что нужно обратить внимание при выборе парсера:

- Платный или бесплатный парсер. Первые приложения обычно качественнее, имеют техническую поддержку. Вторые хуже, но зато бесплатные, так что они будут интересны для решения простых задач.

- С какими площадками работает парсер. Если нужно собирать контакты юридических лиц, то необходима программа, которая будет парсить, заполнять формы (это иногда нужно для получения электроадреса). Если требуются контакты физических лиц, то в первую очередь надо работать с социальными сетями.

- Специализированные парсеры и более общие. Разумеется, лучше выбирать приложения, которые специализируются на нахождении email-адресов. В них будет больше функций. Например, они могут сохранять разосланные письма, их историю.

- Наличие тех или иных функций. Чтобы найти подходящих потенциальных клиентов (а не собирать все контакты подряд), нужно указывать ключевые слова (которые должны быть на веб-площадке), географическое положение и другие данные. Будет полезно, если в приложении будут функции для составления, сохранения писем, сегментации людей.

- Онлайновые и десктопные парсеры. Первые работают на порталах создателей, а человек приобретает лишь подписку, вторые покупатели устанавливают на свой компьютер. Онлайновые программы могут использовать большие мощности, имеют хорошую техподдержку, не нагружают компьютер клиента. Десктопные приложения находятся под лучшим контролем, но отнимают ресурсы компьютера.

Возможности и преимушества#

Многопоточность и производительность

- A-Parser работает на основе последних версий NodeJS и JavaScript движка V8

- AsyncHTTPX — собственная реализация HTTP движка с поддержкой HTTP/1.1 и HTTP/2, HTTPS/TLS, поддержка прокси HTTP/SOCKS4/SOCKS5 с опциональной авторизацией

- в зависимости от конфигурации компьютера и решаемой задачи

- Каждое задание(набор запросов) парсится в указанное число потоков

- При использовании нескольких парсеров в одном задании каждый запрос к разным парсерам выполняется в разных потоках одновременно

- Парсер умеет запускать несколько заданий параллельно

- также проходит в многопоточном режиме

Создание собственных парсеров

- Возможность создания парсеров без написания кода

- Использование регулярных выражений

- Поддержка многостраничного парсинга

- Вложенный парсинг — возможность

- Полноценная : разбор и формирование

- их для обработки полученных результатов прямо в парсере

Создание парсеров на языке JavaScript

- Богатое встроенное API на основе async/await

- Поддержка

- Возможность подключения любых NodeJS модулей

- Управление Chrome/Chromium через puppeteer с поддержкой раздельных прокси для каждой вкладки

Мощные инструменты для формирования запросов и результатов

- Конструктор запросов и результатов — позволяет видоизменять данные(поиск и замена, выделение домена из ссылки, преобразования по регулярным выражениям, XPath…)

- : из файла; перебор слов, символов и цифр, в том числе с заданным шагом

- Фильтрация результатов — по вхождению подстроки, равенству, больше\меньше

- Уникализация результатов — по строке, по домену, по главному домену(A-Parser знает все домены верхнего уровня, в т.ч. такие как co.uk, msk.ru)

- Мощный шаблонизатор результатов на основе — позволяет выводить результаты в любом удобном виде(текстом, csv, html, xml, произвольный формат)

- В парсере используется система пресетов — для каждого парсера можно создать множество предустановленных настроек для различных ситуаций

- Настроить можно все — никаких рамок и ограничений

- и настроек позволяет легко обмениваться опытом с другими пользователями

API

- Возможность интегрировать и управлять парсером из своих программ и скриптов

- Полная автоматизация бизнес-процессов

- Клиенты для PHP, NodeJs, Perl и Python

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

- Оптимальный — если в штате есть программист (а еще лучше — несколько программистов). Поставьте задачу, опишите требования и получите готовый инструмент, заточенный конкретно под ваши задачи. Инструмент можно будет донастраивать и улучшать при необходимости.

- Воспользоваться готовыми облачными парсерами (есть как бесплатные, так и платные сервисы).

- Десктопные парсеры — как правило, программы с мощным функционалом и возможностью гибкой настройки. Но почти все — платные.

- Заказать разработку парсера «под себя» у компаний, специализирующихся на разработке (этот вариант явно не для желающих сэкономить).

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Популярные парсеры для SEO

PromoPult

Данный парсер метатегов и заголовков позволяет убрать дубли метатегов, а также выявить неинформативные заголовки, будучи особо полезным при анализе SEO конкурентов. Первые пятьсот запросов – бесплатно, а далее придется заплатить 0,01 рубля за запрос при объеме от десяти тысяч.

Работа сервиса происходит «в облаке», а для начала потребуется добавить список URL и указать страницы, парсинг которых следует осуществить. Благодаря данному парсеру можно проанализировать ключевые слова, используемые конкурентами с целью оптимизации страниц сайта, а также изучить, как происходит формирование заголовков.

Предназначен для комплексного анализа сайтов, что позволяет провести анализ основных SEO-параметров, осуществить технический анализ сайта, а также импортировать данные как из Google Аналитики, так и Яндекс.Метрики. Предоставляется тестовый период длительностью в 14 дней, а стоимость начинается от 19 долларов в месяц.

Screaming Frog SEO Spider

Данный парсер является идеальным решением для любых SEO-задач. Лицензию на год можно приобрести за 149 фунтов, однако есть и бесплатная версия, отличающаяся ограниченным функционалом, в то время как количество URL для парсинга не может превышать отметку в пятьсот.

ComparseR

С помощью данного десктопного парсера можно выявить страницы, которые обходит поисковый робот во время сканирования сайта, а также провести технический анализ портала. Есть демоверсия с некоторыми ограничениями, а лицензию можно приобрести за две тысячи рублей.

Анализ от PR-CY

Представляет собой онлайн-ресурс для анализа сайтов по достаточно подробному списку параметров. Минимальный тариф составляет 990 рублей в месяц, а тестирование, с полным доступом к функционалу, можно провести в течение семи дней.

Анализ от SE Ranking

Стоимость минимального тарифа данного облачного сервиса составляет от семи долларов в месяц, при оформлении годовой подписки, причем возможна как подписка, так и оплата за каждую проверку. Сервис позволяет проверить скорость загрузки страниц, проанализировать метатеги. Выявить технические ошибки, а также провести анализ внутренних ссылок.

Xenu`s Link Sleuth

Данный бесплатный десктопный парсер предназначен для Windows и используется для парсинга всех URL, имеющихся на сайте, а также применяется с целью обнаружения неработающих ссылок.

Представляет собой SEO-комбайн, отличающийся многофункциональностью, причем минимальный тарифный план лицензии, носящей пожизненный характер, составляет 119 долларов, в то время как максимальный – 279. Демоверсия присутствует. Данный инструмент позволяет осуществить парсинг ключевых слов и провести мониторинг позиций, занимаемых сайтом в поисковых системах.

Для чего парсить номера телефонов в «ВК»

Парсинг контактов дает возможность предпринимателям взаимодействовать с аудиторией, с подписчиками сообществ. Получив список телефонов, вы можете использовать его такими способами:

- Обзвон. Вы можете поручить звонки потенциальной аудитории своим сотрудникам, если в вашей фирме имеется кол-центр и они исполнительные. Когда телефонных номеров мало, то можно самостоятельно обзванивать пользователей.

- СМС-рассылка. Используя таким способом телефоны, у вас появляется возможность быстрого оповещения клиентов о том, что проводится определенная акция. Вы отправляете им сообщения с рекламой.

Прежде, чем начать парсинг номеров, необходимо спарсить целевую аудиторию, получить список ID людей, которым могут быть интересны ваши товары и услуги.

Законно ли это?

Законодательство РФ не предусматривает какого-либо запрета на сбор информации, размещенной в открытом доступе, причем соответствующее право на сбор, равно как и распространение информации, используя для этого любые законные способы, закреплено в Конституции.

Так, в том случае, если требуется осуществить парсинг цен с сайта конкурента, то это не будет противоречить законодательству, так как подобная информация размещена в открытом доступе, а использование парсинга лишь ускоряет время для ее получения. Однако если при помощи парсера планируется собрать персональные данные пользователей, с последующим их использованием в таргетированной рекламе, то здесь уже будет иметь место нарушение закона о защите персональных данных.

ListGrabber

Listgrabber специализируется на создании списков потенциальных клиентов и получении данных из множества источников

Listgrabber гарантирует получение всей важной информации. Платформа может использовать онлайн-каталоги, сайты ассоциаций, каталоги членов и списки MLS – Listgrabber обещает простой сбор нужной информации

Функции:

- Передача данных в один клик

- Точность

- Быстрый поиск лидов

- Обработка нескольких адресов электронной почты

- Горячие клавиши

- Автоматические обновления

- Извлечение почты

- Определение дубликатов

Особенности:

- Извлекает деловые адреса из онлайн-каталогов

- Помогает вам генерировать лиды намного быстрее

- Помогает создавать деловые списки рассылки

Плюсы:

- Использует Excel для извлечения информации и для ее размещения, чтобы пользователи могли проводить рассылки

- Поддерживает Желтые страницы Австралии

Минусы:

- Нужно покупать новые версии каждый год, чтобы продолжать использовать богатые функции, которые предлагает это приложение

- Если вы хотите работать с большими объемами информации, скорее всего этот инструмент даст сбой

Цены:

Вы можете приобрести лицензию ListGrabber со следующими ценами, 1 лицензия – 249.95 доллара, 2 лицензии – 449 долларов, 5 лицензий – 1,059 доллара. Наконец, 20 лицензионных пакетов стоит 3,984 долларов, это скидка в 20%.

Оценка:

3 из 5

- https://prime-ltd.su/blog/parsing-email-adresov/

- https://xmldatafeed.com/13-luchshih-instrumentov-parsinga-adresov-elektronnoj-pochty-dlya-poiska-klientov-v-2020-godu/

Skrapp.io

Специальный инструмент для получения B2B адресов электронной почты – он помогает получать сами адреса и связываться с ними, что значительно повышает эффективность деятельности. Skyrapp понимает, насколько важен ваш бизнес, именно поэтому он гарантирует, что вы будете получать только проверенные адреса компаний. Skrapp может работать с любым источником, будь то Linkedin, веб-сайт конкретной компании и т.п..

Функции

- Находит подтвержденные адреса на Linkedin

- Находит лиды на сайтах компаний

- Находит подтвержденные адреса электронной почты для всех, кого вы хотите

- Получает адреса электронной почты любой организации

- Находит все электронные письма в базе данных

Особенности:

- Расширение Chrome

- Поиск электронной почты

- Поиск сразу множества адресов

- Поиск по домену

- API

Плюсы:

- Автоматическое извлечение множества потенциальных адресов из одного источника

- Простой интерфейс, облегчающий понимание

Минусы:

- Пользователи утверждают, что получают и неправильные адреса

- Плохая поддержка клиентов, связанная с запросами skyrapp.io.

Цена:

Skyrapp имеет 5 тарифов. Первый – бесплатный, второй – “Для начинающих” (49 долларов в месяц), третий – “Для ищущих” (99 долларов в месяц), четвертый – “Для предприятий” (199 долларов в месяц) и, наконец, пятый вариант оплаты – “Глобальный”, который вы можете получить за 299 долларов в месяц. В зависимости от плана, вы ограничиваетесь количеством адресов. Чем дороже пакет, тем больше адресов электронной почты и количество пользователей.

Оценка:

3.4 из 5